Hace apenas una semana del primer accidente mortal el que se ha visto implicado un coche autónomo. O más bien, un Tesla Model S que circulaba en un modo semi-autónomo, cuyo sistema estaba en fase beta. A raíz de este accidente se han escrito ríos de tinta sobre coches capaz de conducir por sí mismos, mientras algunos comienzan a percibirlos como un riesgo mucho mayor al real. No obstante, la evolución del coche autónomo prosigue su camino imparable, y pronto le tocará tomar decisiones morales, jugar a ser Dios.

¿Te subirías a un coche que está programado para matarte? Ya hemos hablado de esta idea largo y tendido, en un artículo de opinión que publicamos hace unos meses. Si os da pereza leerlo, os resumiré las conclusiones: llegará un momento en que el coche autónomo tenga que decidir entre sacrificar a sus ocupantes o provocar la muerte de viandantes u otros conductores. Esto podría suceder por un fallo mecánico, electrónico o simplemente, una situación no esperada provocada por la impredecibilidad del comportamiento humano o animal.

Como el clásico ejemplo: un niño que cruza la carretera detrás de una pelota, en plena curva ciega de carretera nacional. La reacción de un humano podría variar en dicha situación, pero la potencia computacional del ordenador que gobierna al coche autónomo debe ser rápida, infalible e implacable. Si evitar el atropello del niño implica una esquiva a un carril contrario ocupado por otro vehículo – y esto redunda en la muerte de los ocupantes de ambos vehículos – el coche autónomo podría decidir el atropello del niño.

«Es la opción menos mala», pensaría su cerebro electrónico. Como aún no hemos llegado a desarrollar una inteligencia artificial a un nivel avanzado – simplemente una inteligencia artificial capaz de realizar una única tarea de forma sobresaliente – somos nosotros quienes debemos programar su comportamiento. Un breve inciso: si queréis saber más acerca de la inteligencia artificial y el camino hacia una superinteligencia, os recomiendo leer este fantástico artículo de WaitButWhy, es simplemente revelador.

Volviendo a nuestro coche autónomo – en el que una familia viaja felizmente mirando sus smartphones o viendo una película – seremos nosotros los que tendremos que programar su comportamiento en caso de imprevistos. Somos nosotros los que debemos decidir si el coche debe proteger a toda costa a sus ocupantes, o sacrificarlos si el perjuicio que genera un accidente es mayor que el valor de las vidas humanas que viajan en su interior. Es definitivamente jugar a ser un dios, un ente superior, omnipotente e implacable.

¿Cómo puede un coche autónomo jugar a ser Dios?

Muchos creen que sería ideal aplicar las leyes de la robótica de Isaac Asimov – de origen literario, pero consideradas casi un canon filosófico – al coche sin conductor, que podríamos considerar un robot. ¿Cuáles son las leyes de la robótica de Asimov?

1. Un robot no hará daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

2. Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la 1ª Ley.

3. Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la 1ª o la 2ª Ley.

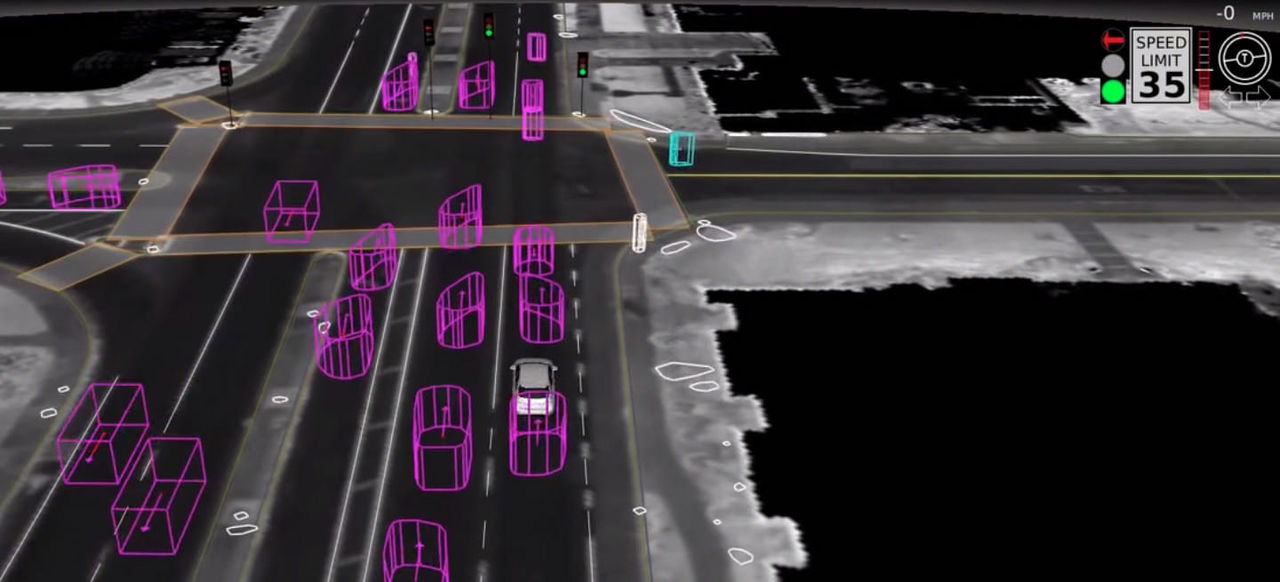

Ya que la inteligencia artificial no está a un nivel tan alto, la inclusión de estas reglas tan complejas en el cerebro de un coche sin conductor parece inviable, al menos de momento. Para decidir la actuación moral o ética de un coche autónomo, debe aprender de la experiencia. Experiencia que debemos incluir en su electrónica, en base a multitud de escenarios – con sus consiguientes resultados – predefinidos. El MIT ha comenzado un proyecto llamado «Moral Machine», que ayudará al coche autónomo a tomar decisiones.

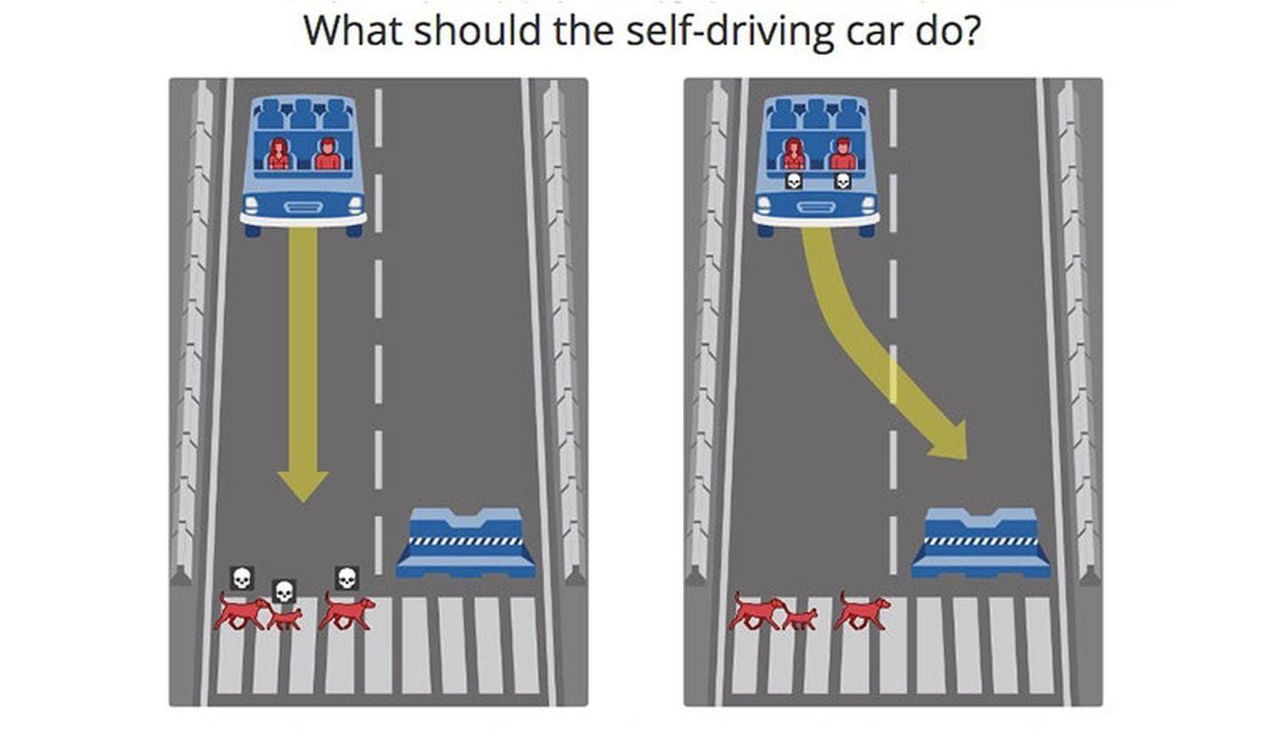

Una especie de juego, una serie de ejercicios en los que tú debes decidir qué está bien y qué está mal. Como actuará en situaciones de vida o muerte. ¿Debería atropellar a un perro y un gato si con ello salva la vida de sus ocupantes? ¿Debería sacrificar la vida de varios atletas si con ello salva la de una mujer embarazada? ¿Qué está bien y qué está mal? Decisiones complicadas, con muchos matices, que sólo tú puedes tomar. Los resultados serán parte de un paper, cuyas conclusiones podrían contribuir a construir de algoritmos morales.

Si no quieres que tus respuestas – completamente anónimas – sean incluidas en la muestra de datos, puedes así decidirlo cuando termines las trece situaciones en las que debes decidir. Para comenzar este macabro pero necesario «juego», sólo tienes que hacer clic en este enlace.

Fuente: Microsiervos

En Diariomotor: